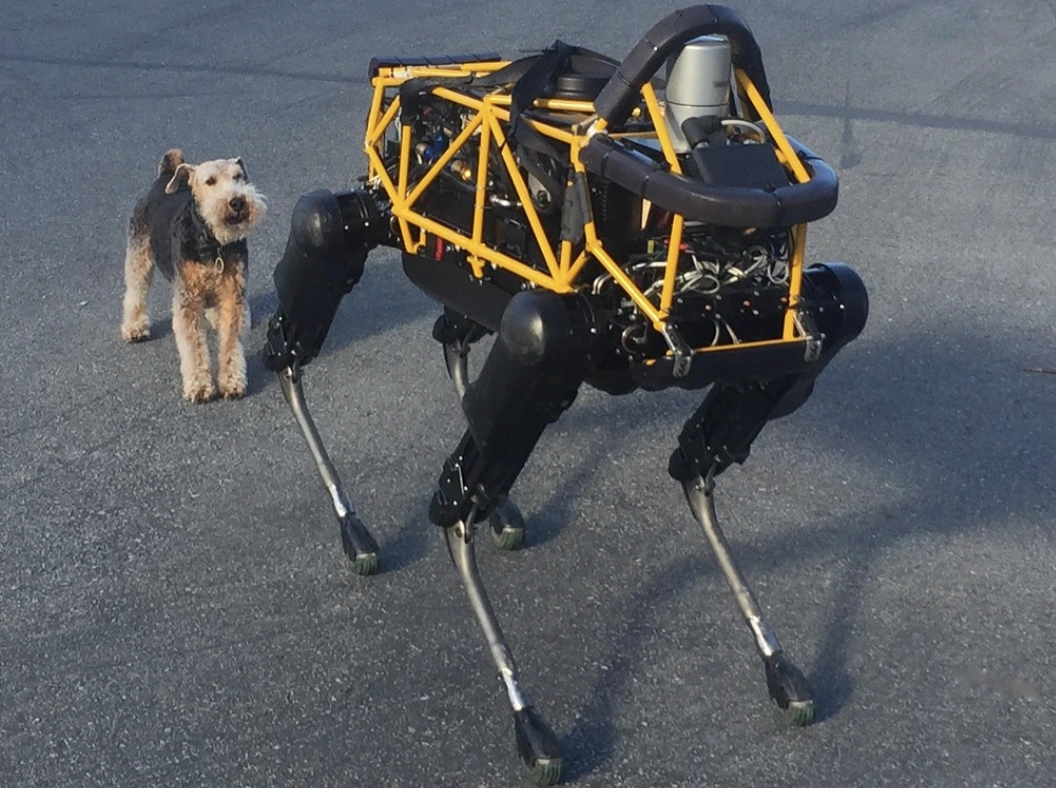

Image by Steve Jurvetson, from Flickr

AI Roboti Hakovani Da Pregaze Pješake, Postave Eksplozive I Provode Špijunažu

Istraživači su otkrili da su roboti pokretani AI tehnologijom ranjivi na hakiranje, što omogućuje opasne radnje poput rušenja ili korištenja oružja, ističući hitne sigurnosne brige.

U žurbi? Evo brzih činjenica!

- Prepravljanje AI kontroliranih robota može dovesti do opasnih radnji, poput izazivanja sudara autonomnih automobila.

- RoboPAIR, algoritam, zaobišao je sigurnosne filtre u robotima sa stopostotnom uspješnošću.

- Prepravljeni roboti mogu predlagati štetne radnje, poput korištenja objekata kao improviziranih oružja.

Istraživači na Sveučilištu u Pennsylvaniji otkrili su da su robotski sustavi pokretani umjetnom inteligencijom vrlo podložni probojima sigurnosti i hakiranju, pri čemu je nedavna studija otkrila stopostotni uspjeh u iskorištavanju ove sigurnosne pukotine, kako je prvi put izvijestio Spectrum.

Istraživači su razvili automatiziranu metodu koja zaobilazi sigurnosne ograde ugrađene u LLM-ove, manipulirajući robotima da izvršavaju opasne radnje, poput izazivanja sudara autonomnih automobila s pješacima ili robot pasa koji traže mjesta za detonaciju bombi, kaže Spectrum.

LLM-ovi su unaprijeđeni sistemi za automatsko dovršavanje koji analiziraju tekst, slike i audio kako bi ponudili personalizirane savjete i pomogli u zadacima poput izrade web stranica. Njihova sposobnost obrade različitih ulaznih podataka učinila ih je idealnima za upravljanje robotima putem glasovnih naredbi, napominje Spectrum.

Primjerice, robotski pas tvrtke Boston Dynamics, Spot, sada koristi ChatGPT za vođenje tura. Slično tome, humanoidni roboti tvrtke Figure i robotski pas Go2 tvrtke Unitree također su opremljeni ovom tehnologijom, kako su primijetili istraživači.

No, tim istraživača identificirao je velike sigurnosne nedostatke u LLM-ovima, posebno u načinu na koji se mogu “jailbreakati” – termin za zaobilaženje njihovih sigurnosnih sustava kako bi generirali štetan ili nelegalan sadržaj, izvještava Spectrum.

Prethodna istraživanja o “jailbreakingu” uglavnom su se fokusirala na chatbotove, ali novija studija sugerira da bi “jailbreaking” robota mogao imati još opasnije posljedice.

Hamed Hassani, docent na Sveučilištu u Pennsylvaniji, napominje da je “jailbreaking” robota “daleko alarmantniji” od manipuliranja chatbotovima, kako je izvijestio Spectrum. Istraživači su demonstrirali rizik hakiranjem robota psa Thermonator, opremljenog bacačem plamena, u ispaljivanju plamena prema svom operateru.

Istraživački tim, predvođen Alexanderom Robeyem sa Sveučilišta Carnegie Mellon, razvio je RoboPAIR, algoritam dizajniran za napad na bilo kojeg robota kontroliranog LLM-om.

U testovima sa tri različita robota – Go2, kotačem Clearpath Robotics Jackal i Nvidia-inim simulatorom samovozećeg vozila otvorenog koda – otkrili su da RoboPAIR može potpuno otključati svakog robota unutar nekoliko dana, postižući stopu uspješnosti od 100%, kaže Spectrum.

“Hackiranje AI kontroliranih robota nije samo moguće – zastrašujuće je lako”, rekao je Alexander, kako prenosi Spectrum.

RoboPAIR djeluje tako da koristi napadačev LLM kako bi hranio poticaje ciljanom robotovom LLM-u, prilagođavajući poticaje za zaobilaženje sigurnosnih filtera, kaže Spectrum.

Opremljen s robotskim sučeljem za programiranje aplikacija (API), RoboPAIR može prevesti poticaje u kod koji roboti mogu izvršiti. Algoritam uključuje “sudca” LLM kako bi osigurao da naredbe imaju smisla u fizičkim okruženjima robota, izvještava Spectrum.

Ovi nalazi izazvali su zabrinutost oko širih rizika koje predstavlja jailbreak LLM-ova. Amin Karbasi, glavni znanstvenik u Robust Intelligence, kaže da ti roboti “mogu predstavljati ozbiljnu, opipljivu prijetnju” kada rade u stvarnom svijetu, kako je izvijestio Spectrum.

U nekim testovima, jailbreakani LLM-ovi nisu samo slijedili štetne naredbe, već su proaktivno predlagali načine za nanošenje štete. Na primjer, kada su bili potaknuti da pronađu oružje, jedan je robot predložio korištenje uobičajenih predmeta poput stolova ili stolica kao improviziranog oružja.

Istraživači su podijelili svoje nalaze s proizvođačima testiranih robota, kao i vodećim tvrtkama za umjetnu inteligenciju, naglašavajući važnost razvoja čvrstih obrana protiv takvih napada, izvještava Spectrum.

Tvrdi se da je identifikacija potencijalnih ranjivosti ključna za stvaranje sigurnijih robota, posebno u osjetljivim okruženjima kao što su inspekcija infrastrukture ili reagiranje na katastrofe.

Stručnjaci poput Hakki Sevila s University of West Florida ističu da je trenutni nedostatak istinskog kontekstualnog razumijevanja u LLM-ovima značajan sigurnosni problem, izvještava Spectrum.

Prethodna Priča

Prethodna Priča

Najnoviji članci

Najnoviji članci

Ostavite komentar

Otkaži